Les robots d’exploration Web tels que le Googlebot, mais aussi notre crawler SISTRIX, se sont développés de manière significative ces dernières années. Alors que dans le passé, seul le HTML était évalué, désormais ce sont des navigateurs complets qui exécutent Javascript et d’autres ressources.

Il est important ici que les données individuelles présentes dans un processus de rendering ne puissent pas être lues ou même modifiées par d’autres processus de rendering. Cela concerne naturellement le contenu des cookies bien connus mais également de nombreuses autres options de stockage de données dans le navigateur.

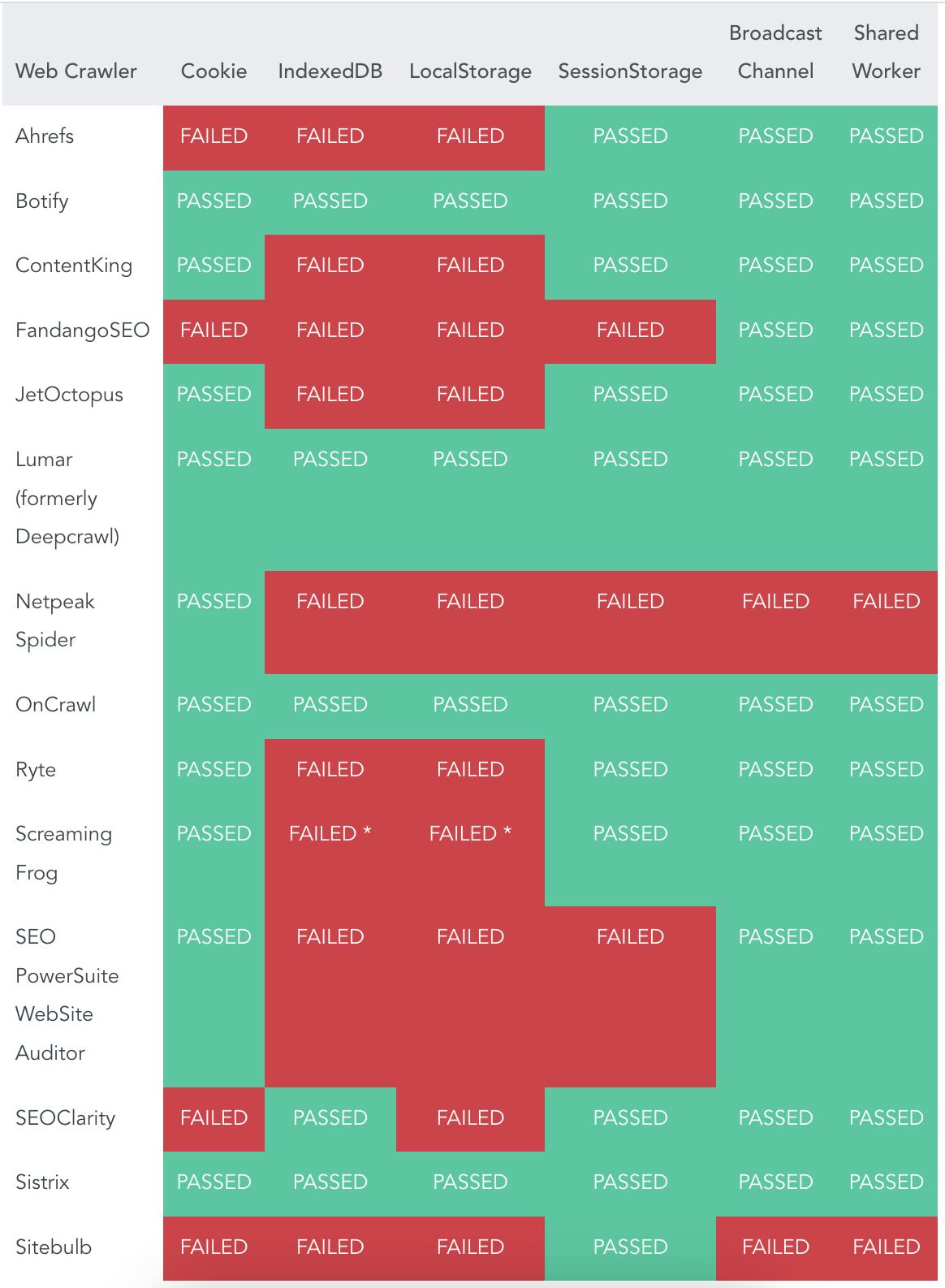

Merj, une société de conseil pour les sujets numériques, a maintenant mené une étude approfondie pour analyser dans quelle mesure cela fonctionne avec les robots d’exploration Onpage des outils de SEO courants. Six options de stockage différentes ont été évaluées à l’aide des robots d’exploration de 14 fournisseurs. Les résultats en un coup d’œil :

Je suis très heureux que notre robot d’exploration Onpage soit l’un des quatre robots d’exploration qui ont passé tous les tests avec brio. Nous sommes en plus le seul fournisseur d’une solution SEO complète à y être parvenu.